Dify 简介

Dify 是一个开源大型语言模型 (LLM) 应用程序开发平台,旨在弥合 AI 应用程序原型设计与生产部署之间的差距。本文为希望了解或扩展该平台的开发者和技术用户提供了 Dify 架构、组件和功能的技术概述。

平台概述

Dify 提供端到端解决方案,通过可视化工具和 API 的组合,构建基于 LLM 的应用程序。其架构旨在支持 AI 应用程序开发的整个生命周期,包括模型集成、提示、知识管理、工作流编排和部署。

主要特点

Dify 提供了多项核心功能,使其在 LLM 应用程序开发生态系统中脱颖而出:

- 可视化工作流构建器 :在可视化画布上构建和测试 AI 应用程序工作流

- 全面的模型支持 :与来自不同供应商的专有和开源 LLM 集成

- 提示管理 :用于制作、测试和优化提示的 IDE

- RAG Pipeline :端到端检索增强生成功能

- Agent 功能 :支持基于 LLM 的代理,并集成工具

- 可观察性 :人工智能应用的监控和分析

- API-First 架构 :所有功能均可通过 REST API 使用

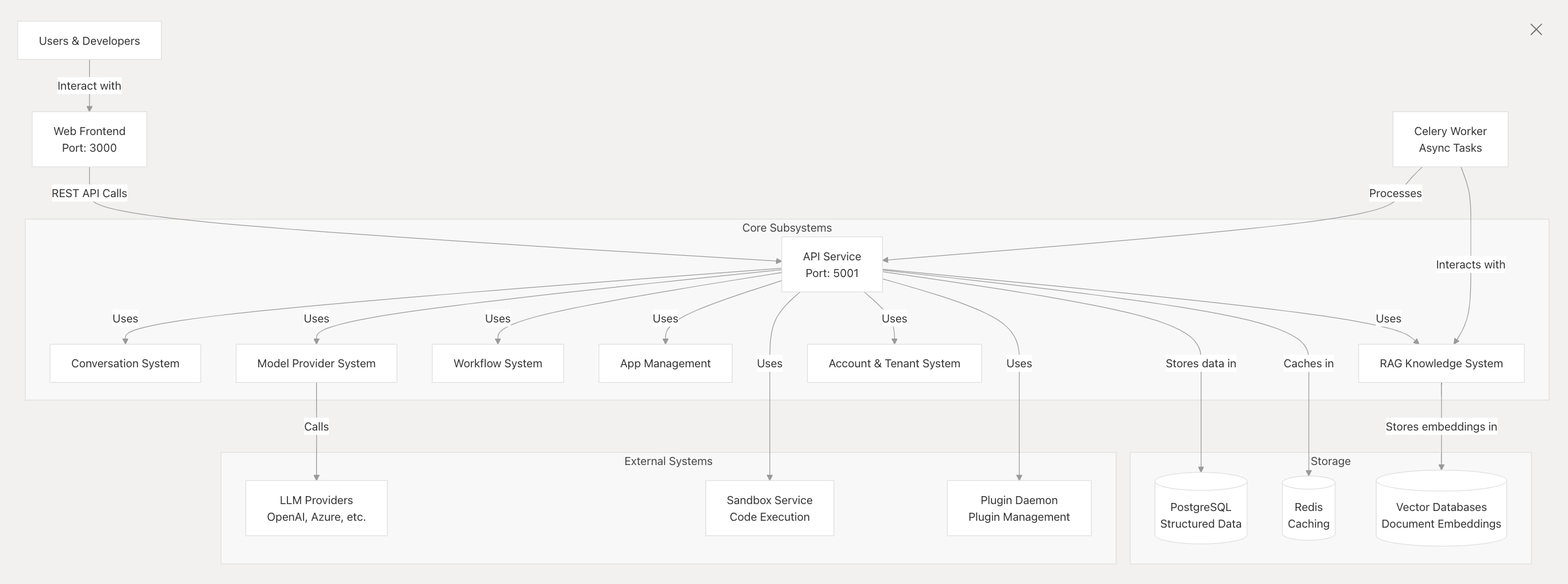

系统架构

Dify 遵循现代 Web 应用程序架构,前端和后端组件之间有明确的分离。

核心组件

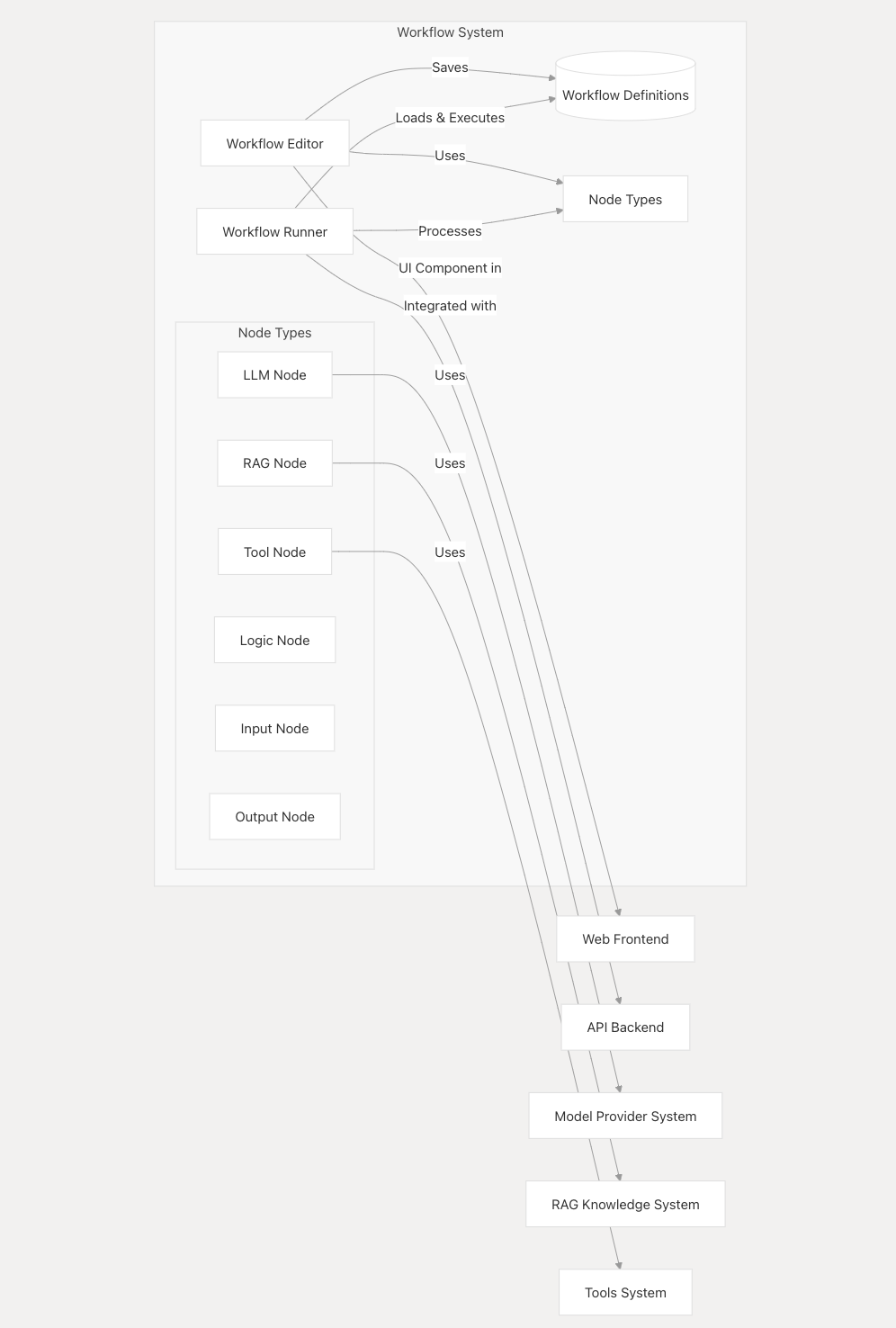

Web 前端

Web 前端为应用程序开发人员和最终用户提供了用户界面。它提供了各种工具,包括工作流构建器、提示编辑器、数据集管理和应用程序测试。

API 后端

API 后端是 Dify 的核心组件,提供 REST API 来支持前端并实现外部集成。它管理对话、知识检索、工作流和模型交互。

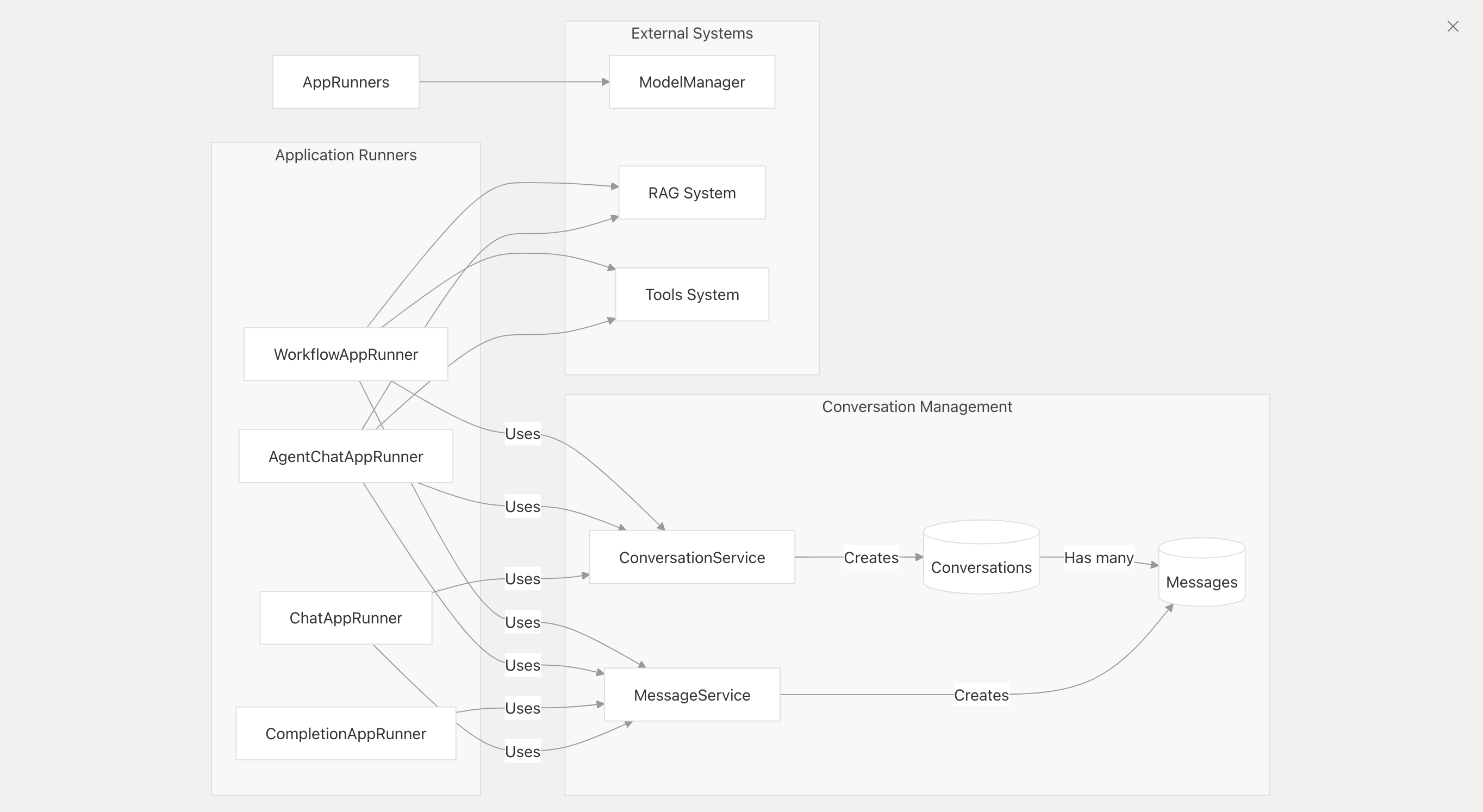

对话系统

对话系统处理聊天会话和消息管理,支持各种类型的应用程序运行器:

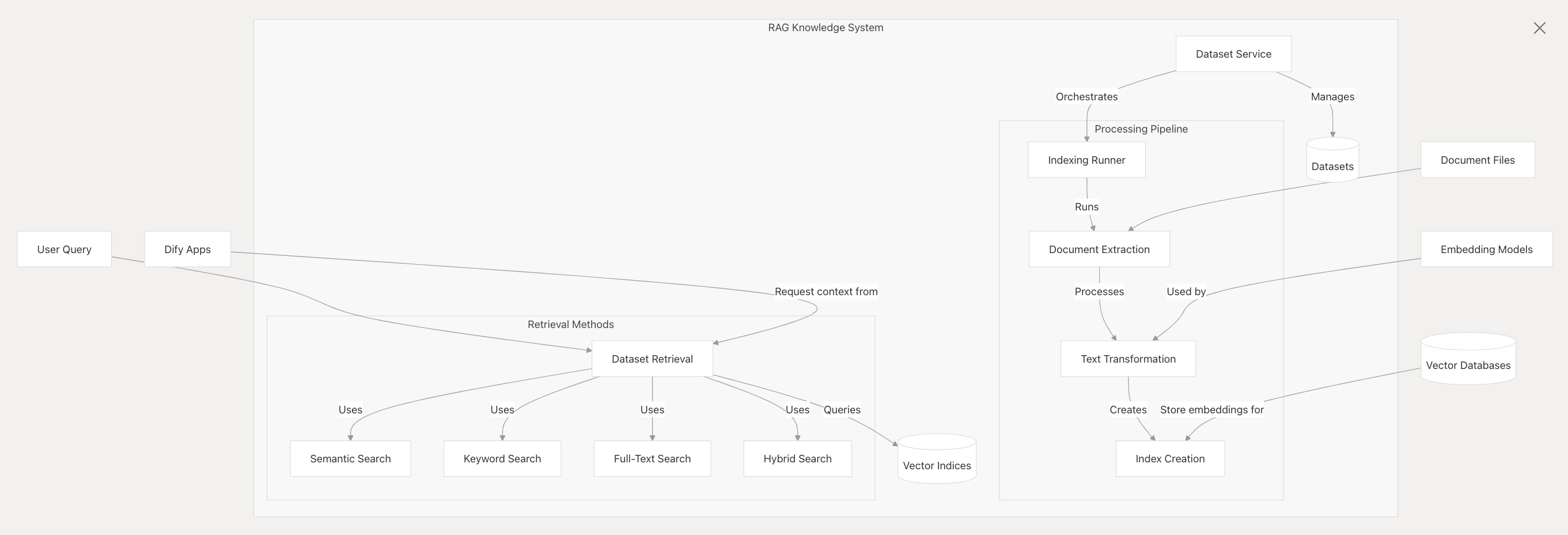

RAG 知识系统

RAG(检索增强生成)知识系统使应用程序能够通过以下方式利用基于文档的知识:

- 文档提取 :处理各种文档格式

- 分块和嵌入 :将文本转换为矢量表示

- 知识检索 :查找与用户查询相关的信息

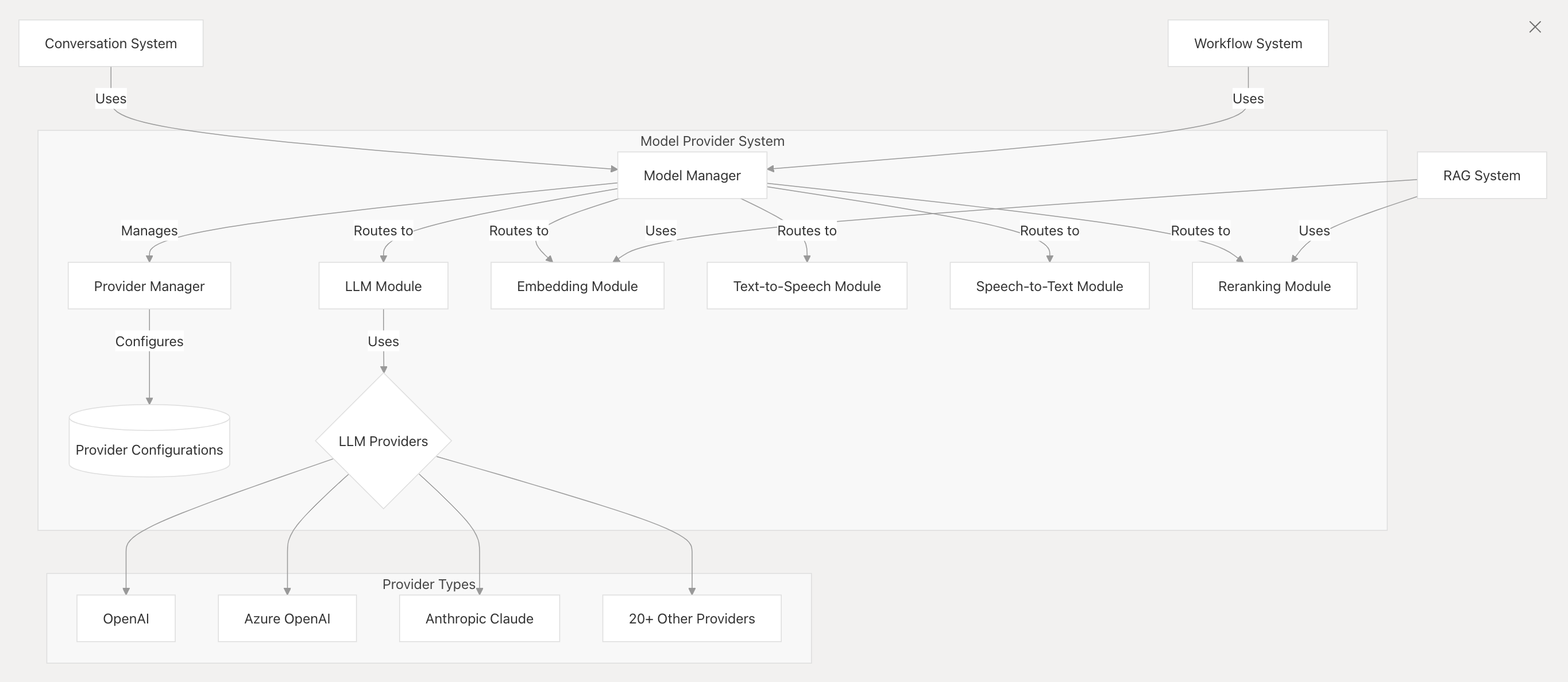

模型提供者系统

模型提供程序系统抽象了与各种 LLM 提供程序的交互,为以下方面提供了统一的接口:

- LLM 文本生成 :完成和聊天完成

- 文本嵌入 :文本的矢量表示

- 文本转语音和语音转文本 :语音功能

- 重新排序 :提高 RAG 结果的相关性

工作流系统

工作流系统支持可视化创建和执行复杂的 AI 应用程序流程,将不同的组件连接成有凝聚力的应用程序。

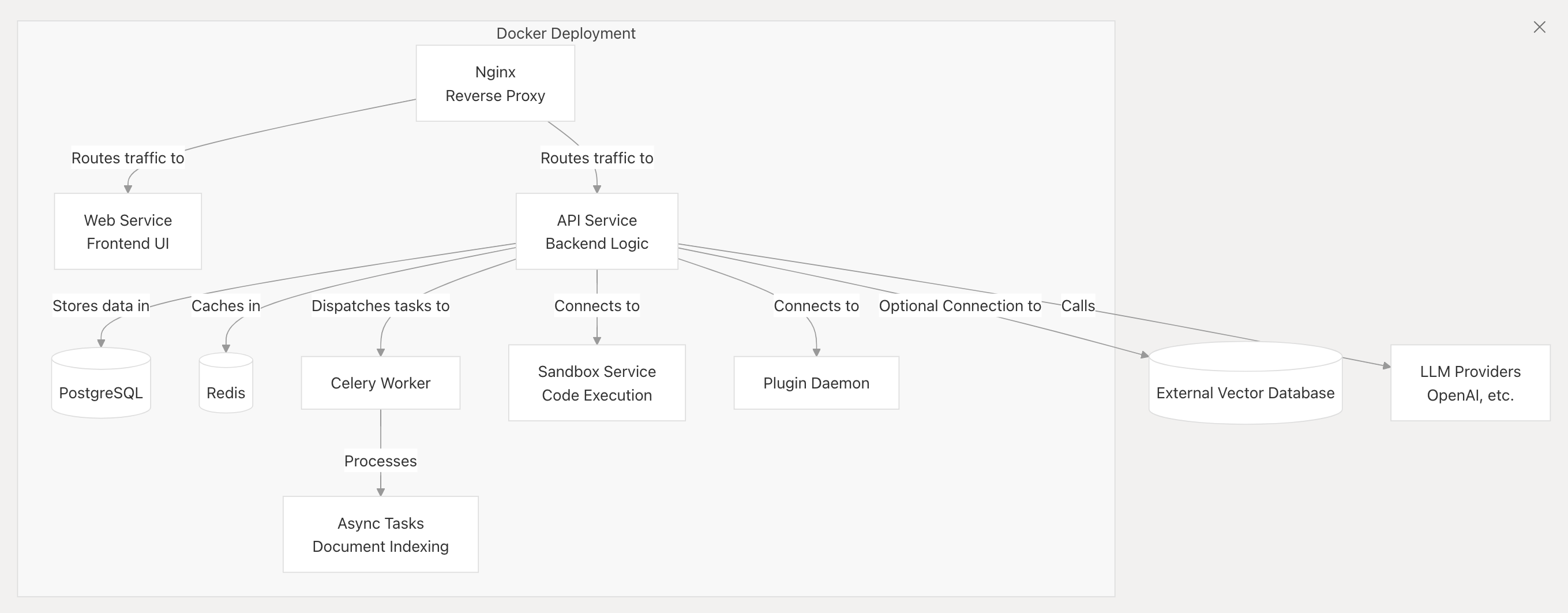

部署选项

根据您的需求,Dify 可以通过多种方式部署:

- Dify Cloud :无需设置的托管服务

- 自托管社区版 :基于 Docker 部署

- 企业版 :增强组织使用功能

标准部署使用 Docker Compose 并包括以下服务:

代码结构

Dify 代码库分为几个主要目录:

| Directory 目录 | Description 描述 |

|---|---|

/api |

Backend API service code 后端 API 服务代码 |

/web |

Frontend React application 前端 React 应用程序 |

/docker |

Deployment configuration files 部署配置文件 |

/sandbox |

Code execution service 代码执行服务 |

后端遵循面向服务的架构,不同模块之间的关注点明确分离。

结论

Dify 提供了一个全面的平台,用于开发基于 LLM 的应用程序,从简单的聊天机器人到复杂的基于代理的系统,应有尽有。其架构支持可视化开发和基于 API 的集成,适用于各种用例和开发方法。

推荐阅读

- A2A 与 MCP 协议的深度融合:智能体生态的互补性与协同

- 手把手实操!我用扣子搭建了一个漫画生成的Agent

- 最简单的方式把 AI Agent 讲明白、用明白 - 来自著名 Agent 框架 Agno 创始人的优质分享

- 大模型应用开发从小工到专家

- AI Agent 视觉指南:通过 60 张可视化图表透视智能体

参考资料

https://github.com/langgenius/dify

欢迎关注公众号,更及时的接收消息,后续会继续写一些相关 LLM 的文章。